2021. 6. 14. 01:56ㆍAI-딥러닝/딥러닝

활성화 함수는 원하는 최종정답을 위해 가까워지게 도와주는 함수입니다.

다시 말하면, 뉴런을 말그대로 활성화 시켜주는 함수라고 이해하면 좋을 것 같습니다.

즉, 활성화 함수가 단순한 뉴런의 단순한 곱셈의 합이 아닙니다. 어떤 정답의 표현력을 위한 함수이기 때문에 다름 수식이 정해진 함수입니다.

좀 더 활성화함수를 더 깊게 설명하면, 활성화함수는 "선형함수"와 "비선형함수"로 나눠진다.

선형함수는 정리하면 단순한 함수다. 즉, 뭔가 복잡한 계산이 필요없다.

복잡한 계산이 필요없다는 것은

은닉층의 망이 깊어지지 않고, 아무리 깊어지더라도 한개 층의 은닉층으로 신경망 구현이 가능해진다.

또는

망이 깊어지지 않는다는 뜻은 학습데이터가 단순화 된다는 뜻이며, 필요한 연산수가 적어지고.. 학습데이터가 적어 정확한 답이 나오기 힘들어진다.

또 다시 정리하면....우리는 어떤 정답을 찾기 위해 다가다야하는데... 정답에 도달하기도 전에 수식이 끝나서

컴퓨터 입장에서는 이게 정답이야 라고 계산 결과를 냈지만 ... 원하는 정답이랑 완전 먼 정답이 나오는 것이다...

(뇌피셜)

이런 함수의 예시를 보여주면 이해가 될 것이다. 대표적으로 함수로는 계단함수가 있고,

알고리즘으로는 퍼셉트론 알고리즘이 있다.

퍼셉트론은 은닉층이 없는 단순 뉴런 세개로 이루어진 신경망이며,

계단함수는 복잡한 수식을 거치지 않는 함수이다.

비선형함수는 선형함수랑 반대라고 생각하면 된다.

비선형함수를 쓰면 계산해야 하는 은닉층의 수가 많아진다는 뜻이며, 은닉층이 많아진다는 것은 더 정확한 정답데이터를 추출할 수

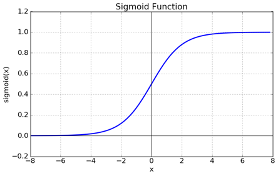

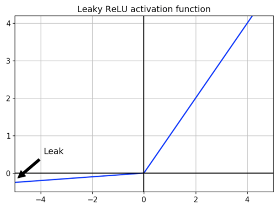

있다는 뜻이 됩니다. 대표적인 비선형함수로는 시그모이드 함수, tanh 함수, ReLU 함수가 있다.

지금까지는 회귀함수에 대해 설명한 것이지만... 단순 분류를 위한 함수가 따로 있다.

바로 "소프트맥스 함수"인데 Softmax(소프트맥스)는 입력받은 값을 출력으로 0~1사이의 값으로 모두 정규화하며 출력 값들의 총합은 항상 1이 되는 특성을 가진 함수이다.

'AI-딥러닝 > 딥러닝' 카테고리의 다른 글

| 딥러닝 - 손실함수 (0) | 2021.06.14 |

|---|---|

| 딥러닝 - 역전파(back propagation) (0) | 2021.06.14 |

| 딥러닝 - 순전파 (0) | 2021.06.14 |

| 딥러닝 - 뉴런을 모아 네트워크화 (0) | 2021.06.13 |

| 딥러닝 - 뉴런 (0) | 2021.06.13 |