2021. 6. 14. 11:23ㆍAI-딥러닝/딥러닝

손실함수가 무엇일까? 손실함수는 영어로 Loss function입니다.

손실함수는 출력값과 오차를 정의하는 함수로서 오차함수나 비용함수라고도 부릅니다. 여기서 말하는 오차는 정답과 출력값의 차이를 의미합니다.

오차값이 클수록 신경망이 바람직한 상태에서 멀어져 있는 것입니다.

학습은 이 오차를 최소화시키도록 진행됩니다.

손실함수에는 다양한 종류가 있는데 딥러닝에서는 일반적으로 “오차제곱합” 또는 “교차 엔트로피 오차”가 많이 사용됩니다.

<오차제곱합>

출력층의 모든 뉴런에서 출력값과 정답의 차이를 제곱하고 이 값들을 모두 합한 것을 “오차제곱합”이라고 부릅니다.

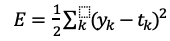

오차제곱합 함수에서 E를 오차 제곱의 합, y_k 를 출력층의 각 출력값, t_k를 정답이라고 할 때 다음과 같은 공식으로 나타낼 수 있습니다.

오차제곱합을 이용하면 신경망의 출력값이 정답과 어느정도 일치하는지 정량화(수량화?) 할 수 있으며, 오차제곱합은 출력값과 정답이 연속적인 수치인 경우에 잘 맞기 때문에 회귀 문제에 자주 사용 된다고 합니다.

<교차엔트로피 오차>

두 분포간의 차이를 나타내는 척도로서 분류 문제에서 많이 사용됩니다.

교차 엔트로피 오차는 출력값 y_k 의 자연로그와 정답의 곱을 모두 더한 값에 마이너스 기호를 붙인 식으로 표현됩니다.

분류 문제에서 정답은 1이 하나이고 나머지는 모두 0인 원핫 인코딩으로 표현됩니다.

따라서 우변의 시그마 내부에서 t_k가 1인 항의 오차 에만 영향을 주고 t_k가 0 인 항에는 영향을 주지 않습니다.

따라서 정답은 1인 하나의 항에만 오차에 영향을 주게 됩니다.

결국 이 값들을 이용하여 손실률을 따지고 여러 수치 값을 조정하게 되는 겁니다.

'AI-딥러닝 > 딥러닝' 카테고리의 다른 글

| 딥러닝 - 경사하강법 기울기 연산 (0) | 2021.06.14 |

|---|---|

| 딥러닝 - 경사하강법 (0) | 2021.06.14 |

| 딥러닝 - 역전파(back propagation) (0) | 2021.06.14 |

| 딥러닝 - 활성화 함수 (0) | 2021.06.14 |

| 딥러닝 - 순전파 (0) | 2021.06.14 |